Одной из важных подзадач для оценки и прогнозирования урожайности является картирование культур сельскохозяйственных растений. В последние годы для ее решения активно используются данные дистанционного зондирования, позволяющие оперативно получать информацию о состоянии полей, а также методы искусственного интеллекта. Цель работы — исследование возможностей применения нейросетевых методов для определения культур сельскохозяйственных растений по данным дистанционного зондирования. За основу взяты два различных набора данных: открытый датасет спутниковых снимков PASTIS, а также мозаика аэрофотоснимков Агрофизического научно-исследовательского института, полученная на полях Ленинградской обл. с помощью беспилотной системы «Геоскан 401». Использовались пять моделей сегментации (U-Net, U-Net 3+, DeepLabV3, FCN, Swin Transformer) для обучения и оценивалась их производительность на наборе данных спутниковых изображений. Результаты эксперимента показали, что точность моделей U-Net 3+ и U-Net значительно выше, чем других моделей. При этом перенос моделей, обученных на спутниковых изображениях с низким разрешением, на аэрофотоснимки с высоким разрешением для дальнейшего обучения позволил эффективно улучшить производительность моделей.

- 1. Введение

- 2. Объекты и методы

- 2.1. Набор данных PASTIS

- 2.2. Набор данных АФИ

- 2.3. Методы

- 3. Результаты и их обсуждение

- 4. Заключение

1. Введение

Процесс принятия эффективных управленческих решений в производстве растениеводческой продукции обусловлен множеством сложно предсказуемых факторов, как правило, природного характера. В связи с этим у производителей возникает необходимость регулярного проведения мониторинга состояния сельскохозяйственных посевов, а также прогнозирования урожайности. Особенно актуальны эти задачи для зон рискованного земледелия, где высокий процент возникновения неблагоприятных явлений, таких как засуха или заморозки. Следует отметить, что подобные территории составляют большую часть от общей площади возделываемых земель.

Благодаря развитию технологий дистанционного зондирования и методов искусственного интеллекта появились новые возможности для оперативного недеструктивного обследования состояния сельскохозяйственной территории. Одной из важных подзадач для оценки и прогнозирования урожайности является картирование культур сельскохозяйственных растений. В последние годы активно для этих целей используются спутниковые снимки.

В современных исследованиях, связанных с сегментацией изображений в задачах точного земледелия, все более перспективными становятся нейросетевые подходы. Выделяются в этом направлении такие модели как U-Net, U-Net 3+, FCN, Swin Transformer, DeepLabV3+ и др. В последние годы также представляет интерес подход с переносным обучением. Так, используя его для дообучения предварительно обученных моделей, достигнута высокая точность в задаче классификации гиперспектральных изображений.

Цель работы — изучение возможностей применения нейросетевых методов для определения культур сельскохозяйственных растений по данным дистанционного зондирования.

2. Объекты и методы

Объектами исследования являются изображения сельскохозяйственных полей. В работе за основу взяты два различных набора данных: открытый датасет спутниковых снимков PASTIS, а также мозаика аэрофотоснимков Агрофизического научно-исследовательского института (АФИ).

2.1. Набор данных PASTIS

Он включает 2433 квадратных патча, каждый размером 128×128 пикселей, полученных со спутника Sentinel-2, каждый патч содержит 10 спектральных полос (B02, B03, B04, B05, B06, B07, B08, B8A, B11, B12) с разрешением 10 м.

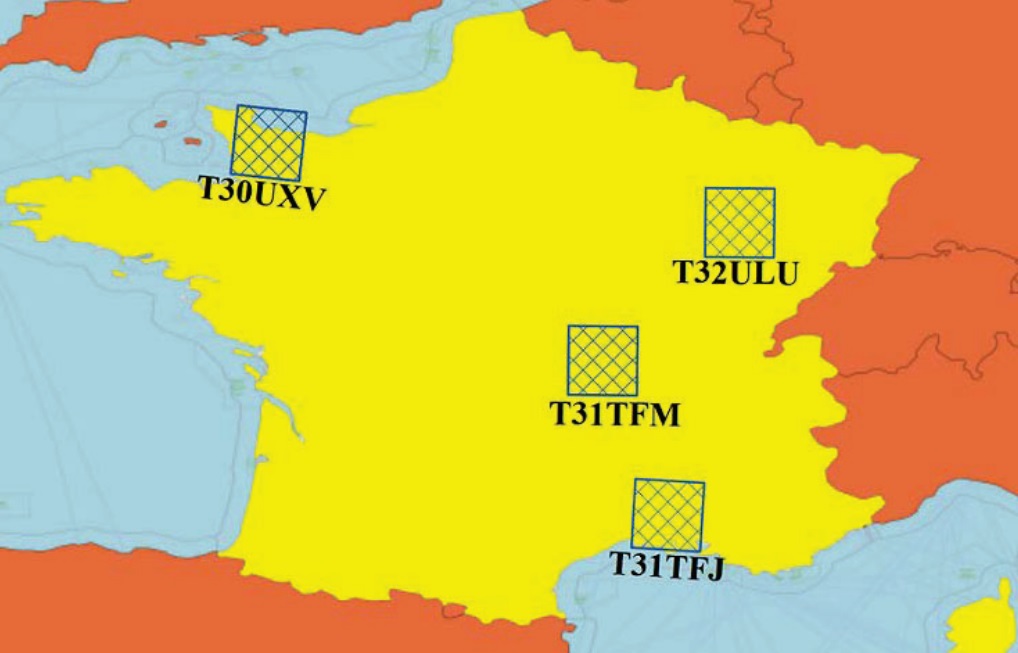

Данные содержат информацию о сельскохозяйственных культурах из разных регионов Франции за период с августа 2018 г. по ноябрь 2019 г., как показано на рис. 1 (изображение взято из документации по использованию PASTIS).

Рис. 1. Местоположение выборок данных спутниковой съемки открытого датасета PASTIS

Каждый патч имеет от 33 до 61 временных образцов. Также представлены различные климатические условия, отражающие реальные условия для сельскохозяйственной идентификации, что значительно помогает в улучшении обобщающей способности модели.

Этот набор данных включает 20 категорий: 18 классов сельскохозяйственных культур, класс фона и пустая метка (табл. 1).

Таблица 1. Перечень классов открытого датасета PASTIS

| Метка | Класс |

| 0 | Background (фон) |

| 1 | Meadow (луг) |

| 2 | Sort winter wheat (мягкая озимая пшеница) |

| 3 | Corn (кукуруза) |

| 4 | Winter barlery (озимый ячмень) |

| 5 | Winter raspesees (озимый рапс) |

| 6 | Spring barley (яровой ячмень) |

| 7 | Sunflower (подсолнух) |

| 8 | Grapevine (виноград) |

| 9 | Beet (свекла) |

| 10 | Winter triticale (озимый тритикале) |

| 11 | Winter durum wheat (озимая твердая пшеница) |

| 12 | Fruits, vegetables, flowers (фрукты, овощи, цветы) |

| 13 | Potatos (картофель) |

| 14 | Leguminous fodder (бобовые корма) |

| 15 | Soybeans (соевые бобы) |

| 16 | Orchard (фруктовый сад) |

| 17 | Mixed cereal (смешанные злаковые) |

| 18 | Sorghum (сорго) |

| 19 | Void label (пустая метка) |

2.2. Набор данных АФИ

Датасет основан на мозаике аэрофотоснимков, полученных в 2017 г. на биополигоне АФИ, расположенном в Ленинградской обл. Съемка осуществлялась с помощью беспилотной авиационной системы «Геоскан 401», оснащенной двумя цифровыми камерами Sony, позволяющими собирать изображения в четырех спектральных каналах: красный (Red), зеленый (Green), синий (Blue), ближний инфракрасный (NIR). Пространственное разрешение составляло 1–5 см/пиксель. Исходные снимки предварительно обрабатывались, в результате были построены ортофотопланы, как, например, на рис. 2.

Разметка датасета АФИ выполнялась вручную, были выбраны семь наиболее представительных категорий — шесть классов сельскохозяйственных культур и класс фона (табл. 2).

Таблица 2. Перечень классов датасета АФИ

| Метка | Класс |

| 0 | Background (фон) |

| 1 | Spring wheat (яровая пшеница) |

| 2 | Galege officinalis (козлятник) |

| 3 | Forb (многолетние травы) |

| 4 | Barley (ячмень) |

| 5 | Potato (картофель) |

| 6 | Spring barley (яровой ячмень) |

| 7 | Jerusalem (топинамбур) |

2.3. Методы

Исследование состоит из двух частей. Первая направлена на анализ результатов обучения пяти выделенных моделей (U-Net, U-Net 3+, FCN, Swin Transformer, DeepLabV3+) на наборе данных спутниковых изображений PASTIS и проверку того, обладают ли модели высокой обобщающей способностью, чтобы справляться с задачами сегментации сельскохозяйственных изображений. Вторая часть направлена на перенос обученных моделей на изображения с беспилотника и анализ их производительности.

Рис. 2. Схема культур растений датасета АФИ 1, 2, 5, 6, 8–12, 14, 16 — сено; 3, 7 — разнотравье; 4 — озимая пшеница; 13 — топинамбур; 15 — овес; 17 — картофель; 18, 22 — пар под озимую пшеницу; 19 — ежа; 20 — яровая пшеница; 21 — тестовый полигон

Экспериментальная схема представлена на рис. 3. В начале эксперимента данные подвергаются предварительной обработке, чтобы изображения соответствовали ожидаемому входу для каждой модели. Количество входных каналов для разных моделей различается. Модели U-Net и U-Net 3+ могут принимать изображения с множеством каналов, в то время как модели DeepLabV3, FCN и Swin Transformer, использующие предварительно обученные модели, принимают только трехканальные изображения.

Рис. 3. Схема обучения моделей

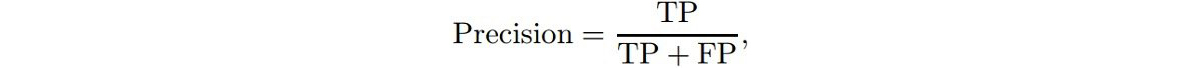

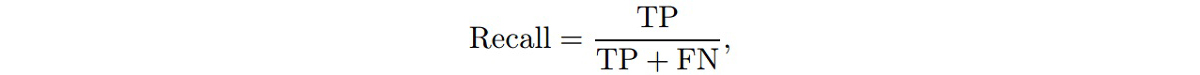

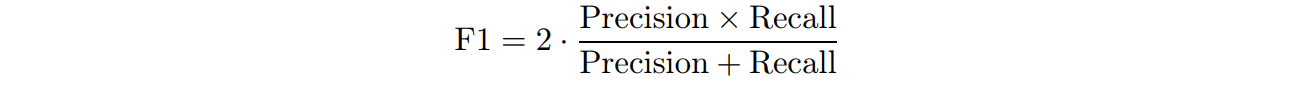

Основными метриками валидации служат параметры Precision, Recall, F1, Overall Accuracy, Mean IoU:

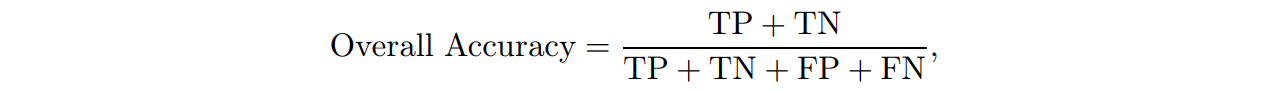

где TP представляет собой истинно положительные результаты (True Positive), а FP — ложно положительные результаты (False Positive); используется для оценки доли истинно положительных результатов среди всех предсказанных положительных результатов;

где FN представляет собой ложно отрицательные результаты (False Negative), т. е. образцы текущей категории, предсказанные как другие категории; применяется для оценки доли истинно положительных результатов среди всех фактически положительных образцов;

объединяет точность и полноту, чтобы сбалансировать их влияние; при плохом качестве тренировочных образцов применение только этих двух показателей может привести к неправильной классификации, потому F1-оценка позволяет модели более всесторонне оценивать наличие экстремальных случаев, что лучше отражает производительность модели на несбалансированных данных;

где TN представляет собой истинно отрицательные результаты; используется для оценки доли правильно предсказанных образцов среди общего числа образцов;

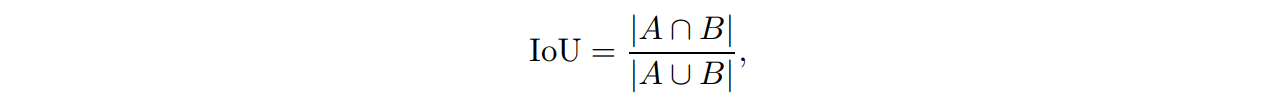

где A представляет собой предсказанную область, а B — реальную область; этот метод оценивает точность предсказания, определяя долю пересечения предсказанных и реальных областей на их объединение, т. е. насколько велика площадь их пересечения;

где N — количество категорий; среднее значение IoU для всех категорий более полно оценивает способность модели к предсказанию.

3. Результаты и их обсуждение

Для обучения применялась видеокарта NVIDIA GeForce RTX 3050Ti, версия CUDA — 12.1, версия torch — 2.2.2+cu121. Было выделено 80% набора данных для обучающего набора, оставшиеся 20% — для валидационного. При загрузке обучающего набора данные перемешивались случайным образом, чтобы предотвратить зависимость модели от них и избегание локальных минимумов. Обучающий и валидационный наборы данных были закреплены в памяти (Pinned Memory), что позволило CUDA напрямую обращаться к этой области памяти, избегая задержек при передаче данных из-за механизма страничной памяти и ускоряя передачу данных из памяти CPU в память GPU. Для предотвращения переобучения и потерь вычислительной мощности использовался механизм ранней остановки (Early Stopping). В качестве функции потерь была выбрана перекрестная энтропия (Crossentropy).

В этом исследовании использовались пять моделей сегментации (U-Net, U-Net 3+, DeepLabV3, FCN, Swin Transformer) для обучения и оценивалась их производительность на наборе данных спутниковых изображений. Результаты по метрикам валидации представлены в табл. 3.

Таблица 3. Результаты по метрикам валидации моделей для датасета PASTIS

| Модель | Параметр, % | ||||

| Precision | Recall | F1 | OA | MIoU | |

| U-Net | 88.86 | 75.60 | 81.69 | 82.20 | 62.60 |

| U-Net 3+ | 90.14 | 80.91 | 85.27 | 84.42 | 64.15 |

| FCN | 82.61 | 75.01 | 78.63 | 82.44 | 61.17 |

| DeeplabV3 | 82.75 | 74.55 | 78.32 | 79.69 | 60.52 |

| Swin Tranformer | 72.86 | 68.01 | 70.35 | 74.49 | 54.14 |

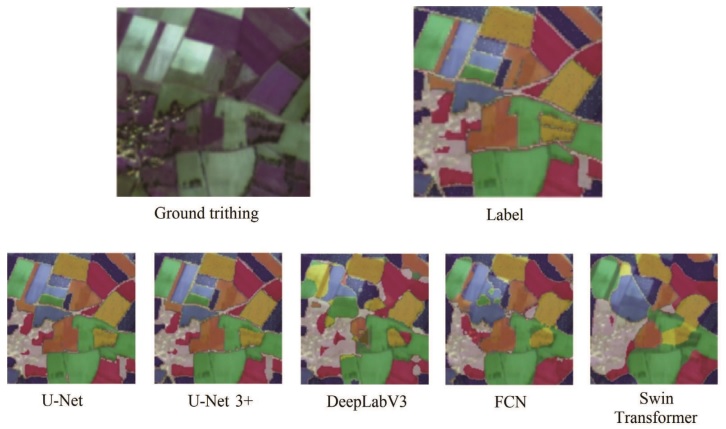

Результаты эксперимента показывают, что точность моделей U-Net 3+ и U-Net значительно превосходит точность других моделей. Это означает, что данные модели способны точнее идентифицировать области с сельскохозяйственными культурами и одновременно уменьшить количество ложных срабатываний на фон. Производительность моделей DeepLabV3 и FCN примерно одинаковая, но немного ниже, чем у первых двух моделей, в то время как точность модели Swin Transformer значительно хуже, она отстает от лучшей модели U-Net 3+ на 17%, что свидетельствует о значительном различии в способности двух моделей различать сельскохозяйственные культуры и фон. Это может быть вызвано разными способами ввода данных в модель. В отличие от моделей FCN и DeepLabV3, которые изменяют входной слой для обработки 10 каналов, Swin Transformer использует только соответствующие RGB три канала для обучения, что приводит к потере информации из семи каналов на этапе ввода, снижая производительность модели по сравнению с другими моделями. Схожие результаты также демонстрирует рис. 4.

Рисунок 4. Результаты картирования классов

Таблица 4. Результаты по метрикам валидации моделей для датасета АФИ

| Модель | Параметр, % | ||||

| Precision | Recall | F1 | OA | MIoU | |

| U-Net | 89.44 | 86.98 | 88.15 | 95.25 | 83.81 |

| U-Net 3+ | 93.77 | 92.84 | 93.29 | 97.18 | 85.64 |

| FCN | 92.35 | 91.93 | 92.13 | 96.67 | 84.78 |

| DeeplabV3 | 92.46 | 91.73 | 92.08 | 96.75 | 84.66 |

| Swin Tranformer | 93.71 | 91.62 | 92.45 | 97.03 | 85.17 |

Путем переноса модели на набор данных АФИ для дальнейшего обучения в этом эксперименте были получены результаты, представленные в табл. 4. Из их анализа видно, что модель U-Net 3+ по-прежнему является лучшей по многим проверочным показателям. Остальные модели показывают схожие результаты, но в отличие от предыдущего переноса модель Swin Transformer демонстрирует очень хорошие результаты по всем показателям. Она не только не является худшей по всем показателям (как в табл. 3), но и по общей оценке уступает лишь модели U-Net 3+. Повышение производительности модели Swin Transformer связано с тем, что изображения с дрона, в отличие от спутниковых изображений, имеют только четыре канала. Помимо RGB трехцветного, они имеют только один дополнительный канал NIR. Поэтому, когда модели U-Net и U-Net 3+ принимают четыре канала, модель Swin Transformer принимает только на один канал меньше, что не приводит к значительной потере характеристик. Кроме того, высокое разрешение аэрофотоснимков и более детализированные особенности обеспечивают модели Swin Transformer более богатые тренировочные данные, что позволяет ей лучше извлекать характеристики и уточнять границы, связанные с категориями образцов.

В табл. 5 представлено общее сравнение полученных результатов.

Таблица 5. Сравнение полученных результатов (%)

| Параметр | U-Net (PASTICS) | U-Net (АФИ) | Swin Transformer (PASTICS) |

Swin Transformer (АФИ) |

| Precision | 88.86 | 89.44 | 72.86 | 93.71 |

| Recall | 75.60 | 86.98 | 68.01 | 91.62 |

| F1 | 81.69 | 88.15 | 70.35 | 9.45 |

| OA | 82.20 | 95.25 | 74.49 | 97.03 |

| MIoU | 62.60 | 83.81 | 50.14 | 85.17 |

По результатам двух экспериментов с обучением легко заметить, что модели могут улучшить свою производительность, если использовать подходящий набор данных для переноса обучения. Например, модели U-Net и Swin Transformer после извлечения признаков на спутниковых изображениях значительно улучшают свои показатели при извлечении признаков на аэрофотоснимках.

4. Заключение

В данной работе проанализирована производительность пяти различных моделей сегментации (U-Net, U-Net 3+, DeepLabV3, FCN, Swin Transformer) в задаче определения сельскохозяйственных культур на спутниковых снимках, а затем с использованием переноса обучения модели были применены на аэрофотоснимках. Модель U-Net 3+ в ходе исследования продемонстрировала лучшие результаты картирования культур среди пяти рассмотренных по всем валидационным показателям при обучении на изображениях как с низким разрешением, так и с высоким. Модель Swin Transformer из-за ограничения числа каналов на входном слое имеет менее широкий диапазон применения, показывая худшие результаты на спутниковых изображениях с мультиспектральными каналами и хорошие результаты только на аэрофотоснимках с меньшим количеством каналов. При этом перенос моделей, обученных на изображениях с низким разрешением, на изображения с высоким разрешением для дальнейшего обучения позволяет эффективно улучшить производительность моделей.

Ссылки на источники, используемые в статье, были удалены. Библиография доступна в оригинальной публикации.

Авторы статьи: Митрофанова О. А., Нин Ся (Санкт-Петербургский государственный университет), Митрофанов Е. П. (Агрофизический научно-исследовательский институт).

Опубликовано в журнале «Вестник Санкт-Петербургского университета», Том 21, № 1, 2025

*Исследование выполнено за счет гранта Российского научного фонда № 24-21-00231.